Serie de vídeos sobre seguridad AI/LLM: Todos los episodios, actualizados semanalmente

Guía de la serie de introducción a la seguridad AI/LLM

Las herramientas de codificación de IA como GitHub Copilot, Cursor y otras están cambiando la forma de crear software, pero también introducen nuevos retos de seguridad que los desarrolladores deben comprender para crear aplicaciones seguras y fiables. Para ayudar a los equipos a adoptar la IA de forma segura, hemos creado una serie de vídeos gratuitos de introducción a la seguridad de la IA/LLM de 12 semanas de duración en YouTube.

Esta entrada es el eje central de la serie. Cada semana, lo actualizaremos con un nuevo vídeo y una descripción, que abarcará conceptos esenciales como la inyección de avisos, el envenenamiento de datos y modelos, los riesgos de la cadena de suministro, los avisos seguros y mucho más. Marque esta página para seguirla semanalmente o suscríbase a nuestro canal de YouTube para recibir todas las lecciones en cuanto se publiquen.

Si quieres profundizar más allá de estas lecciones introductorias, explora la colección completa de AI/LLM en la plataforma SCW o solicita una demo si aún no eres cliente. Suscríbase a nuestro canal de YouTube para ver cada nuevo episodio en cuanto se publique. Y si desea mantenerse conectado con los últimos contenidos, actualizaciones y recursos, regístrese aquí para unirse a nuestra comunidad de desarrolladores y líderes en seguridad.

Episodios (Actualización semanal)

Semana 1 - Riesgos de la codificación con IA: Peligros del uso de LLMs

En este vídeo, exploramos los peligros potenciales del uso de IA/LLMs al escribir código y destacamos los riesgos clave a los que se enfrentan los desarrolladores al integrar herramientas potenciadas por IA en sus flujos de trabajo.

Semana 2 - Ventajas de la codificación de IA: Desarrollo seguro asistido por IA

Lasherramientas de codificación de IAno solo son arriesgadas - cuando se utilizan de forma segura, pueden ayudar a los desarrolladores a trabajar de forma más rápida e inteligente. En este vídeo, exploramos las ventajas de utilizar IA/LLM al escribir código, destacando cómo los equipos pueden aprovechar la IA de forma responsable y evitar al mismo tiempo los errores de seguridad habituales.

Semana 3 - Explicación de la inyección de prompts: Protegiendo el código generado por IALa inyección de prompts es una de las vulnerabilidades más comunes de IA/LLM - y una que todo desarrollador debería saber cómo prevenir. En este vídeo, presentamos

Semana 4 - Divulgación de información sensible: Evitar las fugas de datos de IA

Las herramientas basadas en IA pueden filtrar información confidencial sin querer, poniendo en peligro sus aplicaciones y datos. En este vídeo, cubrimos las vulnerabilidades de divulgación de información sensible, explicamos cómo surgen al utilizar IA/LLM y compartimos medidas prácticas que los desarrolladores pueden tomar para reducir la exposición.

Semana 5 - Riesgos de la cadena de suministro de la IA: Asegurar las dependenciasEldesarrollo asistido por IAacelera la codificación, pero también introduce riesgos en la cadena de suministro que pueden afectar a todas las capas de sus aplicaciones. En este vídeo, exploramos las vulnerabilidades relacionadas con la IA/LLM, explicamos cómo los modelos y las API de terceros pueden ampliar la superficie de ataque y compartimos estrategias para minimizar la exposición.

Semana 6 - Envenenamiento de datos: Asegurar los modelos y resultados de la IALos sistemas deIAson tan seguros como sus datos de entrenamiento, y las entradas comprometidas pueden crear vulnerabilidades que se extienden por todas sus aplicaciones. En este vídeo, presentamos los ataques de envenenamiento de datos y modelos, explicamos cómo las entradas maliciosas pueden manipular las salidas de la IA y compartimos estrategias para proteger sus sistemas.

Semana 7 - Manejo inadecuado de los resultados: Validación del código generado por IA

Lasherramientas basadas en IApueden generar código rápidamente, pero si las salidas no se validan, las vulnerabilidades pueden introducirse sin que nos demos cuenta. En este vídeo, examinamos la gestión inadecuada de los resultados en el desarrollo asistido por IA, explicamos cómo los resultados arriesgados pueden poner en peligro sus aplicaciones y compartimos técnicas para proteger el código generado.

Estos vídeos están diseñados para introducir los conceptos básicos de la seguridad AI/LLM, pero hay mucho más que explorar dentro de la plataformaSecure Code Warrior . Sumérjase en los Desafíos de IA que simulan la revisión y corrección de código asistida por IA en el mundo real, explore nuestras Directrices de IA/LLM alineadas con las mejores prácticas del sector y trabaje a través de Recorridos, Missions, Misiones y Plantillas de cursos que proporcionan experiencia práctica en la creación de hábitos de codificación segura. Para los equipos listos para avanzar en sus habilidades, la plataforma también ofrece una creciente biblioteca de más de 130 actividades de aprendizaje centradas en AI/LLM, incluyendo temas como Codificación con AI, Introducción al riesgo y la seguridad de AI, y los 10 principales de OWASP para aplicaciones LLM. Solicite una demostración para obtener más información.

Su guía todo en uno para nuestra serie de vídeos de seguridad AI/LLM de 12 semanas. Vea todos los episodios, aprenda conceptos clave de seguridad de IA y siga la serie semanalmente.

Shannon Holt es una comercializadora de productos de ciberseguridad con experiencia en seguridad de aplicaciones, servicios de seguridad en la nube y estándares de cumplimiento como PCI-DSS y HITRUST.

Secure Code Warrior está a disposición de su organización para ayudarle a proteger el código a lo largo de todo el ciclo de vida de desarrollo de software y crear una cultura en la que la ciberseguridad sea una prioridad. Tanto si es director de AppSec, desarrollador, CISO o cualquier persona implicada en la seguridad, podemos ayudar a su organización a reducir los riesgos asociados a un código inseguro.

Reservar una demostraciónShannon Holt es una comercializadora de productos de ciberseguridad con experiencia en seguridad de aplicaciones, servicios de seguridad en la nube y estándares de cumplimiento como PCI-DSS y HITRUST.

Shannon Holt es comercializadora de productos de ciberseguridad con experiencia en seguridad de aplicaciones, servicios de seguridad en la nube y estándares de cumplimiento como PCI-DSS y HITRUST. Le apasiona hacer que el desarrollo seguro y el cumplimiento normativo sean más prácticos y accesibles para los equipos técnicos, acortando la distancia entre las expectativas de seguridad y las realidades del desarrollo de software moderno.

Guía de la serie de introducción a la seguridad AI/LLM

Las herramientas de codificación de IA como GitHub Copilot, Cursor y otras están cambiando la forma de crear software, pero también introducen nuevos retos de seguridad que los desarrolladores deben comprender para crear aplicaciones seguras y fiables. Para ayudar a los equipos a adoptar la IA de forma segura, hemos creado una serie de vídeos gratuitos de introducción a la seguridad de la IA/LLM de 12 semanas de duración en YouTube.

Esta entrada es el eje central de la serie. Cada semana, lo actualizaremos con un nuevo vídeo y una descripción, que abarcará conceptos esenciales como la inyección de avisos, el envenenamiento de datos y modelos, los riesgos de la cadena de suministro, los avisos seguros y mucho más. Marque esta página para seguirla semanalmente o suscríbase a nuestro canal de YouTube para recibir todas las lecciones en cuanto se publiquen.

Si quieres profundizar más allá de estas lecciones introductorias, explora la colección completa de AI/LLM en la plataforma SCW o solicita una demo si aún no eres cliente. Suscríbase a nuestro canal de YouTube para ver cada nuevo episodio en cuanto se publique. Y si desea mantenerse conectado con los últimos contenidos, actualizaciones y recursos, regístrese aquí para unirse a nuestra comunidad de desarrolladores y líderes en seguridad.

Episodios (Actualización semanal)

Semana 1 - Riesgos de la codificación con IA: Peligros del uso de LLMs

En este vídeo, exploramos los peligros potenciales del uso de IA/LLMs al escribir código y destacamos los riesgos clave a los que se enfrentan los desarrolladores al integrar herramientas potenciadas por IA en sus flujos de trabajo.

Semana 2 - Ventajas de la codificación de IA: Desarrollo seguro asistido por IA

Lasherramientas de codificación de IAno solo son arriesgadas - cuando se utilizan de forma segura, pueden ayudar a los desarrolladores a trabajar de forma más rápida e inteligente. En este vídeo, exploramos las ventajas de utilizar IA/LLM al escribir código, destacando cómo los equipos pueden aprovechar la IA de forma responsable y evitar al mismo tiempo los errores de seguridad habituales.

Semana 3 - Explicación de la inyección de prompts: Protegiendo el código generado por IALa inyección de prompts es una de las vulnerabilidades más comunes de IA/LLM - y una que todo desarrollador debería saber cómo prevenir. En este vídeo, presentamos

Semana 4 - Divulgación de información sensible: Evitar las fugas de datos de IA

Las herramientas basadas en IA pueden filtrar información confidencial sin querer, poniendo en peligro sus aplicaciones y datos. En este vídeo, cubrimos las vulnerabilidades de divulgación de información sensible, explicamos cómo surgen al utilizar IA/LLM y compartimos medidas prácticas que los desarrolladores pueden tomar para reducir la exposición.

Semana 5 - Riesgos de la cadena de suministro de la IA: Asegurar las dependenciasEldesarrollo asistido por IAacelera la codificación, pero también introduce riesgos en la cadena de suministro que pueden afectar a todas las capas de sus aplicaciones. En este vídeo, exploramos las vulnerabilidades relacionadas con la IA/LLM, explicamos cómo los modelos y las API de terceros pueden ampliar la superficie de ataque y compartimos estrategias para minimizar la exposición.

Semana 6 - Envenenamiento de datos: Asegurar los modelos y resultados de la IALos sistemas deIAson tan seguros como sus datos de entrenamiento, y las entradas comprometidas pueden crear vulnerabilidades que se extienden por todas sus aplicaciones. En este vídeo, presentamos los ataques de envenenamiento de datos y modelos, explicamos cómo las entradas maliciosas pueden manipular las salidas de la IA y compartimos estrategias para proteger sus sistemas.

Semana 7 - Manejo inadecuado de los resultados: Validación del código generado por IA

Lasherramientas basadas en IApueden generar código rápidamente, pero si las salidas no se validan, las vulnerabilidades pueden introducirse sin que nos demos cuenta. En este vídeo, examinamos la gestión inadecuada de los resultados en el desarrollo asistido por IA, explicamos cómo los resultados arriesgados pueden poner en peligro sus aplicaciones y compartimos técnicas para proteger el código generado.

Estos vídeos están diseñados para introducir los conceptos básicos de la seguridad AI/LLM, pero hay mucho más que explorar dentro de la plataformaSecure Code Warrior . Sumérjase en los Desafíos de IA que simulan la revisión y corrección de código asistida por IA en el mundo real, explore nuestras Directrices de IA/LLM alineadas con las mejores prácticas del sector y trabaje a través de Recorridos, Missions, Misiones y Plantillas de cursos que proporcionan experiencia práctica en la creación de hábitos de codificación segura. Para los equipos listos para avanzar en sus habilidades, la plataforma también ofrece una creciente biblioteca de más de 130 actividades de aprendizaje centradas en AI/LLM, incluyendo temas como Codificación con AI, Introducción al riesgo y la seguridad de AI, y los 10 principales de OWASP para aplicaciones LLM. Solicite una demostración para obtener más información.

Guía de la serie de introducción a la seguridad AI/LLM

Las herramientas de codificación de IA como GitHub Copilot, Cursor y otras están cambiando la forma de crear software, pero también introducen nuevos retos de seguridad que los desarrolladores deben comprender para crear aplicaciones seguras y fiables. Para ayudar a los equipos a adoptar la IA de forma segura, hemos creado una serie de vídeos gratuitos de introducción a la seguridad de la IA/LLM de 12 semanas de duración en YouTube.

Esta entrada es el eje central de la serie. Cada semana, lo actualizaremos con un nuevo vídeo y una descripción, que abarcará conceptos esenciales como la inyección de avisos, el envenenamiento de datos y modelos, los riesgos de la cadena de suministro, los avisos seguros y mucho más. Marque esta página para seguirla semanalmente o suscríbase a nuestro canal de YouTube para recibir todas las lecciones en cuanto se publiquen.

Si quieres profundizar más allá de estas lecciones introductorias, explora la colección completa de AI/LLM en la plataforma SCW o solicita una demo si aún no eres cliente. Suscríbase a nuestro canal de YouTube para ver cada nuevo episodio en cuanto se publique. Y si desea mantenerse conectado con los últimos contenidos, actualizaciones y recursos, regístrese aquí para unirse a nuestra comunidad de desarrolladores y líderes en seguridad.

Episodios (Actualización semanal)

Semana 1 - Riesgos de la codificación con IA: Peligros del uso de LLMs

En este vídeo, exploramos los peligros potenciales del uso de IA/LLMs al escribir código y destacamos los riesgos clave a los que se enfrentan los desarrolladores al integrar herramientas potenciadas por IA en sus flujos de trabajo.

Semana 2 - Ventajas de la codificación de IA: Desarrollo seguro asistido por IA

Lasherramientas de codificación de IAno solo son arriesgadas - cuando se utilizan de forma segura, pueden ayudar a los desarrolladores a trabajar de forma más rápida e inteligente. En este vídeo, exploramos las ventajas de utilizar IA/LLM al escribir código, destacando cómo los equipos pueden aprovechar la IA de forma responsable y evitar al mismo tiempo los errores de seguridad habituales.

Semana 3 - Explicación de la inyección de prompts: Protegiendo el código generado por IALa inyección de prompts es una de las vulnerabilidades más comunes de IA/LLM - y una que todo desarrollador debería saber cómo prevenir. En este vídeo, presentamos

Semana 4 - Divulgación de información sensible: Evitar las fugas de datos de IA

Las herramientas basadas en IA pueden filtrar información confidencial sin querer, poniendo en peligro sus aplicaciones y datos. En este vídeo, cubrimos las vulnerabilidades de divulgación de información sensible, explicamos cómo surgen al utilizar IA/LLM y compartimos medidas prácticas que los desarrolladores pueden tomar para reducir la exposición.

Semana 5 - Riesgos de la cadena de suministro de la IA: Asegurar las dependenciasEldesarrollo asistido por IAacelera la codificación, pero también introduce riesgos en la cadena de suministro que pueden afectar a todas las capas de sus aplicaciones. En este vídeo, exploramos las vulnerabilidades relacionadas con la IA/LLM, explicamos cómo los modelos y las API de terceros pueden ampliar la superficie de ataque y compartimos estrategias para minimizar la exposición.

Semana 6 - Envenenamiento de datos: Asegurar los modelos y resultados de la IALos sistemas deIAson tan seguros como sus datos de entrenamiento, y las entradas comprometidas pueden crear vulnerabilidades que se extienden por todas sus aplicaciones. En este vídeo, presentamos los ataques de envenenamiento de datos y modelos, explicamos cómo las entradas maliciosas pueden manipular las salidas de la IA y compartimos estrategias para proteger sus sistemas.

Semana 7 - Manejo inadecuado de los resultados: Validación del código generado por IA

Lasherramientas basadas en IApueden generar código rápidamente, pero si las salidas no se validan, las vulnerabilidades pueden introducirse sin que nos demos cuenta. En este vídeo, examinamos la gestión inadecuada de los resultados en el desarrollo asistido por IA, explicamos cómo los resultados arriesgados pueden poner en peligro sus aplicaciones y compartimos técnicas para proteger el código generado.

Estos vídeos están diseñados para introducir los conceptos básicos de la seguridad AI/LLM, pero hay mucho más que explorar dentro de la plataformaSecure Code Warrior . Sumérjase en los Desafíos de IA que simulan la revisión y corrección de código asistida por IA en el mundo real, explore nuestras Directrices de IA/LLM alineadas con las mejores prácticas del sector y trabaje a través de Recorridos, Missions, Misiones y Plantillas de cursos que proporcionan experiencia práctica en la creación de hábitos de codificación segura. Para los equipos listos para avanzar en sus habilidades, la plataforma también ofrece una creciente biblioteca de más de 130 actividades de aprendizaje centradas en AI/LLM, incluyendo temas como Codificación con AI, Introducción al riesgo y la seguridad de AI, y los 10 principales de OWASP para aplicaciones LLM. Solicite una demostración para obtener más información.

Haga clic en el siguiente enlace y descargue el PDF de este recurso.

Secure Code Warrior está a disposición de su organización para ayudarle a proteger el código a lo largo de todo el ciclo de vida de desarrollo de software y crear una cultura en la que la ciberseguridad sea una prioridad. Tanto si es director de AppSec, desarrollador, CISO o cualquier persona implicada en la seguridad, podemos ayudar a su organización a reducir los riesgos asociados a un código inseguro.

Ver el informeReservar una demostraciónShannon Holt es una comercializadora de productos de ciberseguridad con experiencia en seguridad de aplicaciones, servicios de seguridad en la nube y estándares de cumplimiento como PCI-DSS y HITRUST.

Shannon Holt es comercializadora de productos de ciberseguridad con experiencia en seguridad de aplicaciones, servicios de seguridad en la nube y estándares de cumplimiento como PCI-DSS y HITRUST. Le apasiona hacer que el desarrollo seguro y el cumplimiento normativo sean más prácticos y accesibles para los equipos técnicos, acortando la distancia entre las expectativas de seguridad y las realidades del desarrollo de software moderno.

Guía de la serie de introducción a la seguridad AI/LLM

Las herramientas de codificación de IA como GitHub Copilot, Cursor y otras están cambiando la forma de crear software, pero también introducen nuevos retos de seguridad que los desarrolladores deben comprender para crear aplicaciones seguras y fiables. Para ayudar a los equipos a adoptar la IA de forma segura, hemos creado una serie de vídeos gratuitos de introducción a la seguridad de la IA/LLM de 12 semanas de duración en YouTube.

Esta entrada es el eje central de la serie. Cada semana, lo actualizaremos con un nuevo vídeo y una descripción, que abarcará conceptos esenciales como la inyección de avisos, el envenenamiento de datos y modelos, los riesgos de la cadena de suministro, los avisos seguros y mucho más. Marque esta página para seguirla semanalmente o suscríbase a nuestro canal de YouTube para recibir todas las lecciones en cuanto se publiquen.

Si quieres profundizar más allá de estas lecciones introductorias, explora la colección completa de AI/LLM en la plataforma SCW o solicita una demo si aún no eres cliente. Suscríbase a nuestro canal de YouTube para ver cada nuevo episodio en cuanto se publique. Y si desea mantenerse conectado con los últimos contenidos, actualizaciones y recursos, regístrese aquí para unirse a nuestra comunidad de desarrolladores y líderes en seguridad.

Episodios (Actualización semanal)

Semana 1 - Riesgos de la codificación con IA: Peligros del uso de LLMs

En este vídeo, exploramos los peligros potenciales del uso de IA/LLMs al escribir código y destacamos los riesgos clave a los que se enfrentan los desarrolladores al integrar herramientas potenciadas por IA en sus flujos de trabajo.

Semana 2 - Ventajas de la codificación de IA: Desarrollo seguro asistido por IA

Lasherramientas de codificación de IAno solo son arriesgadas - cuando se utilizan de forma segura, pueden ayudar a los desarrolladores a trabajar de forma más rápida e inteligente. En este vídeo, exploramos las ventajas de utilizar IA/LLM al escribir código, destacando cómo los equipos pueden aprovechar la IA de forma responsable y evitar al mismo tiempo los errores de seguridad habituales.

Semana 3 - Explicación de la inyección de prompts: Protegiendo el código generado por IALa inyección de prompts es una de las vulnerabilidades más comunes de IA/LLM - y una que todo desarrollador debería saber cómo prevenir. En este vídeo, presentamos

Semana 4 - Divulgación de información sensible: Evitar las fugas de datos de IA

Las herramientas basadas en IA pueden filtrar información confidencial sin querer, poniendo en peligro sus aplicaciones y datos. En este vídeo, cubrimos las vulnerabilidades de divulgación de información sensible, explicamos cómo surgen al utilizar IA/LLM y compartimos medidas prácticas que los desarrolladores pueden tomar para reducir la exposición.

Semana 5 - Riesgos de la cadena de suministro de la IA: Asegurar las dependenciasEldesarrollo asistido por IAacelera la codificación, pero también introduce riesgos en la cadena de suministro que pueden afectar a todas las capas de sus aplicaciones. En este vídeo, exploramos las vulnerabilidades relacionadas con la IA/LLM, explicamos cómo los modelos y las API de terceros pueden ampliar la superficie de ataque y compartimos estrategias para minimizar la exposición.

Semana 6 - Envenenamiento de datos: Asegurar los modelos y resultados de la IALos sistemas deIAson tan seguros como sus datos de entrenamiento, y las entradas comprometidas pueden crear vulnerabilidades que se extienden por todas sus aplicaciones. En este vídeo, presentamos los ataques de envenenamiento de datos y modelos, explicamos cómo las entradas maliciosas pueden manipular las salidas de la IA y compartimos estrategias para proteger sus sistemas.

Semana 7 - Manejo inadecuado de los resultados: Validación del código generado por IA

Lasherramientas basadas en IApueden generar código rápidamente, pero si las salidas no se validan, las vulnerabilidades pueden introducirse sin que nos demos cuenta. En este vídeo, examinamos la gestión inadecuada de los resultados en el desarrollo asistido por IA, explicamos cómo los resultados arriesgados pueden poner en peligro sus aplicaciones y compartimos técnicas para proteger el código generado.

Estos vídeos están diseñados para introducir los conceptos básicos de la seguridad AI/LLM, pero hay mucho más que explorar dentro de la plataformaSecure Code Warrior . Sumérjase en los Desafíos de IA que simulan la revisión y corrección de código asistida por IA en el mundo real, explore nuestras Directrices de IA/LLM alineadas con las mejores prácticas del sector y trabaje a través de Recorridos, Missions, Misiones y Plantillas de cursos que proporcionan experiencia práctica en la creación de hábitos de codificación segura. Para los equipos listos para avanzar en sus habilidades, la plataforma también ofrece una creciente biblioteca de más de 130 actividades de aprendizaje centradas en AI/LLM, incluyendo temas como Codificación con AI, Introducción al riesgo y la seguridad de AI, y los 10 principales de OWASP para aplicaciones LLM. Solicite una demostración para obtener más información.

Índice

Shannon Holt es una comercializadora de productos de ciberseguridad con experiencia en seguridad de aplicaciones, servicios de seguridad en la nube y estándares de cumplimiento como PCI-DSS y HITRUST.

Secure Code Warrior está a disposición de su organización para ayudarle a proteger el código a lo largo de todo el ciclo de vida de desarrollo de software y crear una cultura en la que la ciberseguridad sea una prioridad. Tanto si es director de AppSec, desarrollador, CISO o cualquier persona implicada en la seguridad, podemos ayudar a su organización a reducir los riesgos asociados a un código inseguro.

Reservar una demostraciónDescargarRecursos para empezar

A por el oro: Aumentar la seguridad del código en Paysafe

Descubra cómo la asociación de Paysafe con Secure Code Warrior permitió aumentar en un 45% la productividad de los desarrolladores y reducir considerablemente las vulnerabilidades del código.

El poder de la marca en AppSec DevSec DevSecOps (¿Qué hay en un Acrynym?)

En AppSec, el impacto duradero de un programa exige algo más que tecnología: necesita una marca fuerte. Una identidad poderosa garantiza que sus iniciativas resuenen e impulsen un compromiso sostenido dentro de su comunidad de desarrolladores.

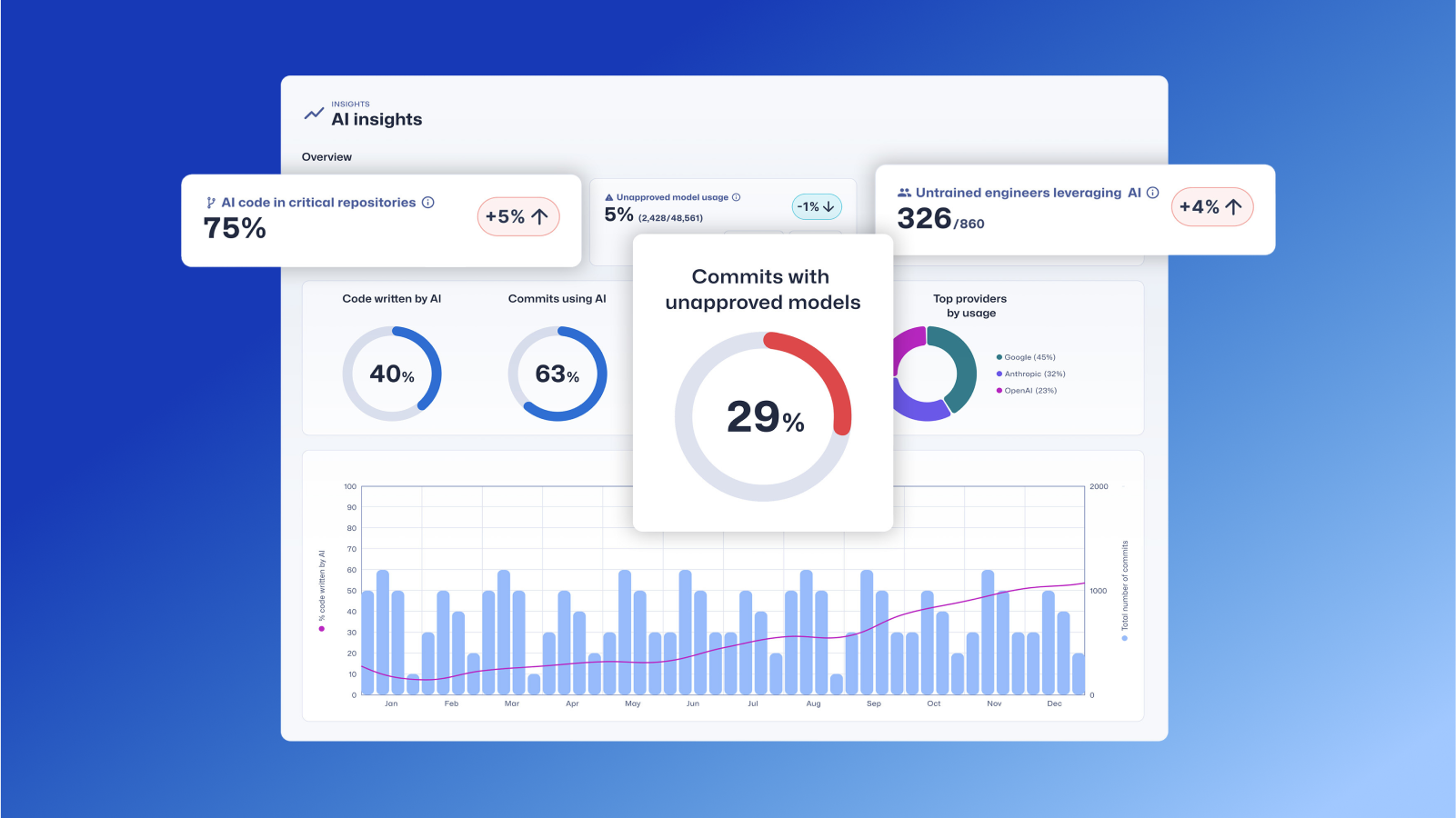

Agente de confianza: AI por Secure Code Warrior

Esta página presenta SCW Trust Agent: AI, un nuevo conjunto de capacidades que proporcionan una profunda observabilidad y gobernanza sobre las herramientas de codificación de IA. Descubra cómo nuestra solución correlaciona de forma única el uso de herramientas de IA con las habilidades de los desarrolladores para ayudarle a gestionar el riesgo, optimizar su SDLC y garantizar que cada línea de código generado por IA sea segura.

Vibe Coding: Guía práctica para actualizar su estrategia AppSec para la IA

Vea el vídeo a la carta para aprender a capacitar a los administradores de AppSec para que se conviertan en facilitadores de IA, en lugar de bloqueadores, mediante un enfoque práctico que da prioridad a la formación. Le mostraremos cómo aprovechar Secure Code Warrior (SCW) para actualizar estratégicamente su estrategia de AppSec para la era de los asistentes de codificación de IA.

Recursos para empezar

Codificación segura en la era de la IA: pruebe nuestros nuevos retos interactivos de IA

La codificación asistida por IA está cambiando el desarrollo. Prueba nuestros nuevos retos de IA al estilo Copilot para revisar, analizar y corregir código de forma segura en flujos de trabajo realistas.

.png)

.avif)

.avif)