SCW Trust Agent: AI - Visibilidad y gobernanza para su SDLC asistido por IA

La adopción generalizada de herramientas de codificación de IA está transformando el desarrollo de software. El 78 % de los desarrolladores1 utilizan ya la IA para aumentar la productividad, por lo que la velocidad de la innovación nunca ha sido mayor. Pero esta rápida aceleración conlleva un riesgo crítico.

Los estudios revelan que hasta el 50% del código funcionalmente correcto generado por IA es inseguro2. No se trata de un pequeño fallo, sino de un reto sistémico. Significa que cada vez que un desarrollador utiliza una herramienta como GitHub Copilot o ChatGPT, podría estar introduciendo sin saberlo nuevas vulnerabilidades en su código base. El resultado es una peligrosa mezcla de velocidad y riesgos de seguridad que la mayoría de las organizaciones no están preparadas para gestionar.

El reto de la "IA en la sombra

Sin una forma de gestionar el uso de herramientas de codificación de IA, los responsables de CISO, AppSec e ingeniería están expuestos a nuevos riesgos que no pueden ver ni medir. Cómo puede responder a preguntas cruciales como:

- ¿Qué porcentaje de nuestro código está generado por IA?

- ¿Qué MCP se están utilizando?

- ¿Qué modelos no aprobados se están utilizando?

- ¿Qué vulnerabilidades generan los distintos modelos?

La falta de visibilidad y gobernanza crea una nueva capa de riesgo e incertidumbre. Es la definición misma de "TI en la sombra", pero para su código base.

Nuestra solución - Trust Agent: AI

Creemos que se puede tener velocidad y seguridad a la vez. Estamos orgullosos de lanzar Trust Agent: AIuna nueva y potente capacidad de nuestro producto Trust Agent que proporciona la capacidad de observación y el control que necesita para adoptar con confianza la IA en su ciclo de vida de desarrollo de software. Mediante una combinación única de señales, Trust Agent: AI proporciona:

- Visibilidad: Vea qué desarrolladores están utilizando qué herramientas de codificación de IA, LLM y MCP, y en qué bases de código. Se acabó la «IA en la sombra».

- Métricas de riesgo: Conecte el código generado por IA con el nivel de conocimientos de un desarrollador y las vulnerabilidades introducidas para comprender el verdadero riesgo que se está introduciendo, a nivel de commit.

- Gobernanza: Automatice la aplicación de políticas para garantizar que los desarrolladores habilitados para IA cumplan las normas de codificación segura.

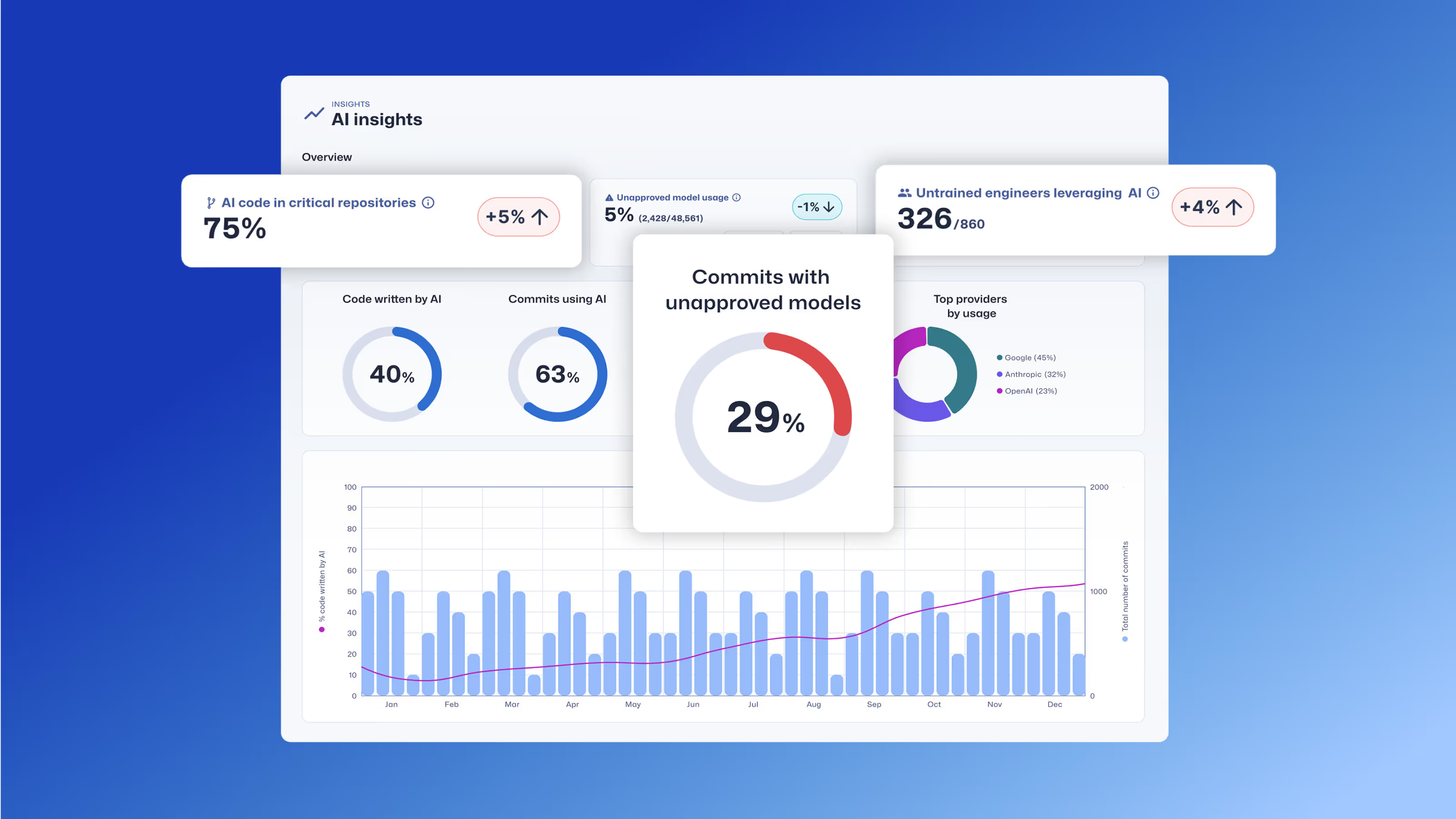

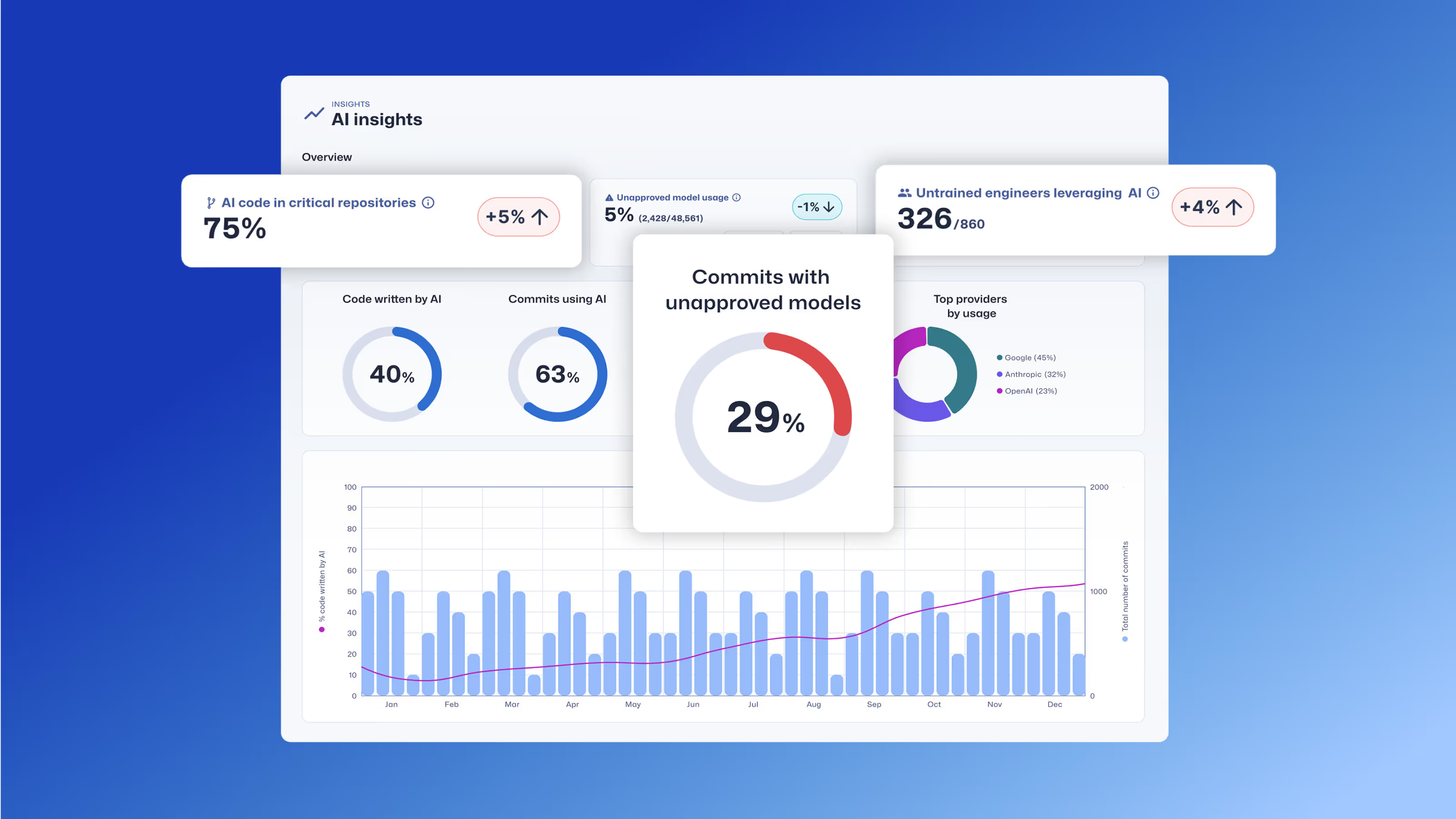

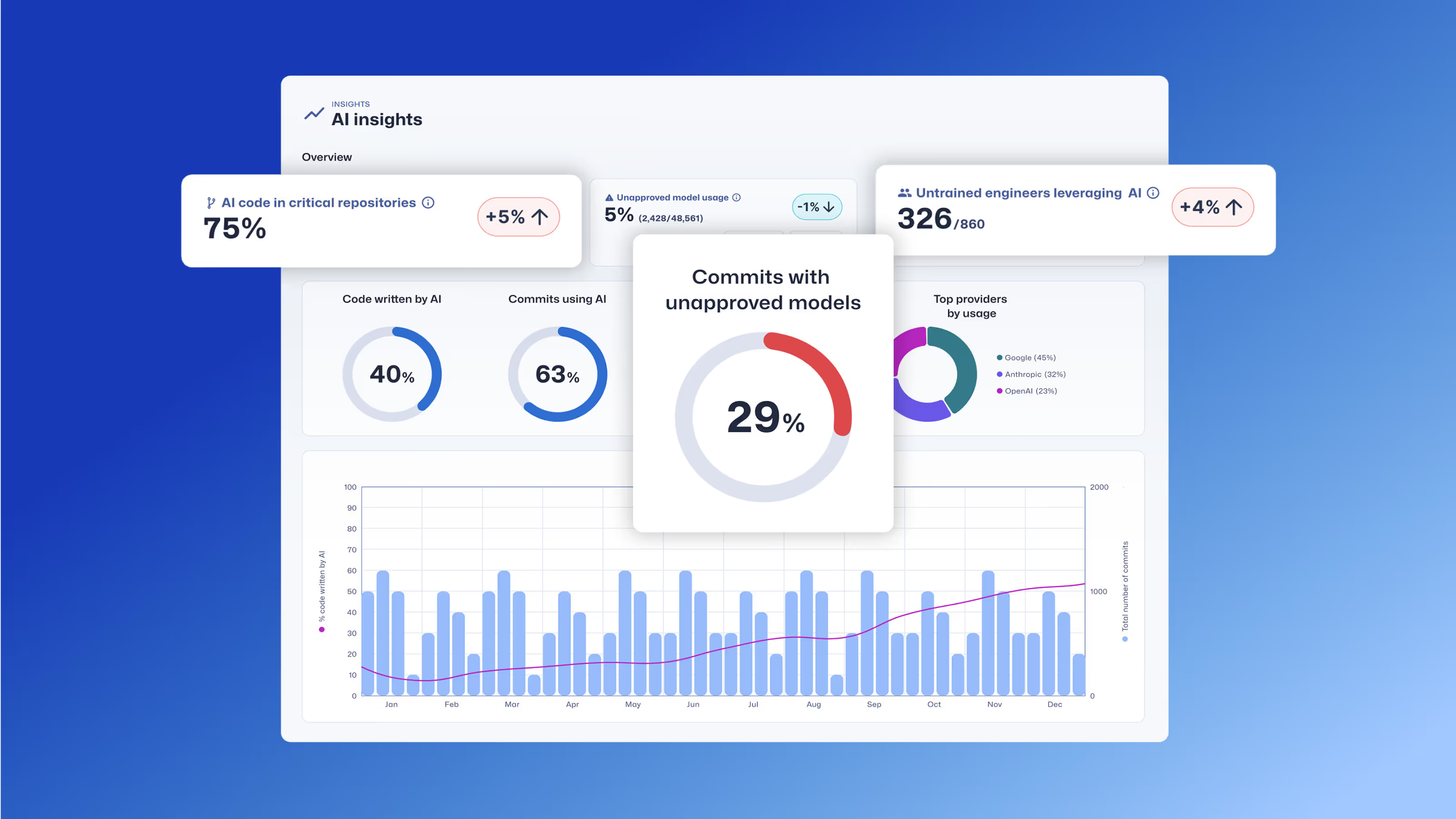

El panel Trust Agent: AI proporciona información sobre el uso de la herramienta de codificación de IA, el desarrollador que contribuye, el repositorio de código y mucho más.

El papel del desarrollador: La última línea de defensa

Aunque Trust Agent: AI le ofrece una gobernanza sin precedentes, sabemos que el desarrollador sigue siendo la última y más crítica línea de defensa. La forma más eficaz de gestionar el riesgo del código generado por IA es asegurarse de que sus desarrolladores cuentan con los conocimientos de seguridad necesarios para revisar, validar y proteger dicho código. Aquí es donde entra en juego SCW Learning, que forma parte de nuestra plataforma integral de gestión de riesgos para desarrolladores. Con SCW Learning, equipamos a sus desarrolladores con las habilidades prácticas que necesitan para aprovechar de forma segura la IA para la productividad. El producto SCW Learning incluye:

- Puntuación de confianza SCW: Una referencia pionera en el sector que cuantifica la competencia en seguridad de los desarrolladores, lo que le permite identificar qué desarrolladores están mejor equipados para manejar código generado por IA.

- Desafíos de IA: Retos de codificación interactivos y reales que enseñan específicamente a los desarrolladores a encontrar y corregir vulnerabilidades en el código generado por IA.

- Aprendizaje dirigido: Rutas de aprendizaje seleccionadas a partir de más de 200 desafíos, directrices, recorridos, Missions, misiones y Courses de IA que refuerzan los principios de codificación segura y ayudan a los desarrolladores a dominar las habilidades de seguridad necesarias para mitigar los riesgos de la IA.

Combinando la potente gobernanza de Trust Agent: AI con el desarrollo de habilidades de nuestro producto de aprendizaje, puede crear un SDLC verdaderamente seguro. Podrá identificar riesgos, aplicar políticas y capacitar a sus desarrolladores para crear código de forma más rápida y segura que nunca.

¿Listo para asegurar su viaje a la IA?

La era de la IA ya está aquí y, como responsable de producto, mi objetivo es crear soluciones que no sólo resuelvan los problemas de hoy, sino que se anticipen a los de mañana. Trust Agent: AI está diseñado para hacer precisamente eso, dándole la visibilidad y el control para gestionar los riesgos de la IA al tiempo que permite a sus equipos innovar. La versión beta de acceso anticipado ya está disponible y nos encantaría que participara en ella. No se trata solo de un nuevo producto, sino de ser pioneros en un nuevo estándar para el desarrollo seguro de software en un mundo en el que prima la IA.

Únase hoy mismo a la lista de espera de acceso anticipado.

Descubra cómo Trust Agent: AI proporciona una gran visibilidad y control sobre el código generado por IA, lo que permite a las organizaciones innovar de forma más rápida y segura.

Secure Code Warrior está a disposición de su organización para ayudarle a proteger el código a lo largo de todo el ciclo de vida de desarrollo de software y crear una cultura en la que la ciberseguridad sea una prioridad. Tanto si es director de AppSec, desarrollador, CISO o cualquier persona implicada en la seguridad, podemos ayudar a su organización a reducir los riesgos asociados a un código inseguro.

Reservar una demostraciónTamim Noorzad, Director de Gestión de Productos en Secure Code Warrior, es un ingeniero reconvertido en gestor de productos con más de 17 años de experiencia, especializado en productos SaaS 0-to-1.

La adopción generalizada de herramientas de codificación de IA está transformando el desarrollo de software. El 78 % de los desarrolladores1 utilizan ya la IA para aumentar la productividad, por lo que la velocidad de la innovación nunca ha sido mayor. Pero esta rápida aceleración conlleva un riesgo crítico.

Los estudios revelan que hasta el 50% del código funcionalmente correcto generado por IA es inseguro2. No se trata de un pequeño fallo, sino de un reto sistémico. Significa que cada vez que un desarrollador utiliza una herramienta como GitHub Copilot o ChatGPT, podría estar introduciendo sin saberlo nuevas vulnerabilidades en su código base. El resultado es una peligrosa mezcla de velocidad y riesgos de seguridad que la mayoría de las organizaciones no están preparadas para gestionar.

El reto de la "IA en la sombra

Sin una forma de gestionar el uso de herramientas de codificación de IA, los responsables de CISO, AppSec e ingeniería están expuestos a nuevos riesgos que no pueden ver ni medir. Cómo puede responder a preguntas cruciales como:

- ¿Qué porcentaje de nuestro código está generado por IA?

- ¿Qué MCP se están utilizando?

- ¿Qué modelos no aprobados se están utilizando?

- ¿Qué vulnerabilidades generan los distintos modelos?

La falta de visibilidad y gobernanza crea una nueva capa de riesgo e incertidumbre. Es la definición misma de "TI en la sombra", pero para su código base.

Nuestra solución - Trust Agent: AI

Creemos que se puede tener velocidad y seguridad a la vez. Estamos orgullosos de lanzar Trust Agent: AIuna nueva y potente capacidad de nuestro producto Trust Agent que proporciona la capacidad de observación y el control que necesita para adoptar con confianza la IA en su ciclo de vida de desarrollo de software. Mediante una combinación única de señales, Trust Agent: AI proporciona:

- Visibilidad: Vea qué desarrolladores están utilizando qué herramientas de codificación de IA, LLM y MCP, y en qué bases de código. Se acabó la «IA en la sombra».

- Métricas de riesgo: Conecte el código generado por IA con el nivel de conocimientos de un desarrollador y las vulnerabilidades introducidas para comprender el verdadero riesgo que se está introduciendo, a nivel de commit.

- Gobernanza: Automatice la aplicación de políticas para garantizar que los desarrolladores habilitados para IA cumplan las normas de codificación segura.

El panel Trust Agent: AI proporciona información sobre el uso de la herramienta de codificación de IA, el desarrollador que contribuye, el repositorio de código y mucho más.

El papel del desarrollador: La última línea de defensa

Aunque Trust Agent: AI le ofrece una gobernanza sin precedentes, sabemos que el desarrollador sigue siendo la última y más crítica línea de defensa. La forma más eficaz de gestionar el riesgo del código generado por IA es asegurarse de que sus desarrolladores cuentan con los conocimientos de seguridad necesarios para revisar, validar y proteger dicho código. Aquí es donde entra en juego SCW Learning, que forma parte de nuestra plataforma integral de gestión de riesgos para desarrolladores. Con SCW Learning, equipamos a sus desarrolladores con las habilidades prácticas que necesitan para aprovechar de forma segura la IA para la productividad. El producto SCW Learning incluye:

- Puntuación de confianza SCW: Una referencia pionera en el sector que cuantifica la competencia en seguridad de los desarrolladores, lo que le permite identificar qué desarrolladores están mejor equipados para manejar código generado por IA.

- Desafíos de IA: Retos de codificación interactivos y reales que enseñan específicamente a los desarrolladores a encontrar y corregir vulnerabilidades en el código generado por IA.

- Aprendizaje dirigido: Rutas de aprendizaje seleccionadas a partir de más de 200 desafíos, directrices, recorridos, Missions, misiones y Courses de IA que refuerzan los principios de codificación segura y ayudan a los desarrolladores a dominar las habilidades de seguridad necesarias para mitigar los riesgos de la IA.

Combinando la potente gobernanza de Trust Agent: AI con el desarrollo de habilidades de nuestro producto de aprendizaje, puede crear un SDLC verdaderamente seguro. Podrá identificar riesgos, aplicar políticas y capacitar a sus desarrolladores para crear código de forma más rápida y segura que nunca.

¿Listo para asegurar su viaje a la IA?

La era de la IA ya está aquí y, como responsable de producto, mi objetivo es crear soluciones que no sólo resuelvan los problemas de hoy, sino que se anticipen a los de mañana. Trust Agent: AI está diseñado para hacer precisamente eso, dándole la visibilidad y el control para gestionar los riesgos de la IA al tiempo que permite a sus equipos innovar. La versión beta de acceso anticipado ya está disponible y nos encantaría que participara en ella. No se trata solo de un nuevo producto, sino de ser pioneros en un nuevo estándar para el desarrollo seguro de software en un mundo en el que prima la IA.

Únase hoy mismo a la lista de espera de acceso anticipado.

La adopción generalizada de herramientas de codificación de IA está transformando el desarrollo de software. El 78 % de los desarrolladores1 utilizan ya la IA para aumentar la productividad, por lo que la velocidad de la innovación nunca ha sido mayor. Pero esta rápida aceleración conlleva un riesgo crítico.

Los estudios revelan que hasta el 50% del código funcionalmente correcto generado por IA es inseguro2. No se trata de un pequeño fallo, sino de un reto sistémico. Significa que cada vez que un desarrollador utiliza una herramienta como GitHub Copilot o ChatGPT, podría estar introduciendo sin saberlo nuevas vulnerabilidades en su código base. El resultado es una peligrosa mezcla de velocidad y riesgos de seguridad que la mayoría de las organizaciones no están preparadas para gestionar.

El reto de la "IA en la sombra

Sin una forma de gestionar el uso de herramientas de codificación de IA, los responsables de CISO, AppSec e ingeniería están expuestos a nuevos riesgos que no pueden ver ni medir. Cómo puede responder a preguntas cruciales como:

- ¿Qué porcentaje de nuestro código está generado por IA?

- ¿Qué MCP se están utilizando?

- ¿Qué modelos no aprobados se están utilizando?

- ¿Qué vulnerabilidades generan los distintos modelos?

La falta de visibilidad y gobernanza crea una nueva capa de riesgo e incertidumbre. Es la definición misma de "TI en la sombra", pero para su código base.

Nuestra solución - Trust Agent: AI

Creemos que se puede tener velocidad y seguridad a la vez. Estamos orgullosos de lanzar Trust Agent: AIuna nueva y potente capacidad de nuestro producto Trust Agent que proporciona la capacidad de observación y el control que necesita para adoptar con confianza la IA en su ciclo de vida de desarrollo de software. Mediante una combinación única de señales, Trust Agent: AI proporciona:

- Visibilidad: Vea qué desarrolladores están utilizando qué herramientas de codificación de IA, LLM y MCP, y en qué bases de código. Se acabó la «IA en la sombra».

- Métricas de riesgo: Conecte el código generado por IA con el nivel de conocimientos de un desarrollador y las vulnerabilidades introducidas para comprender el verdadero riesgo que se está introduciendo, a nivel de commit.

- Gobernanza: Automatice la aplicación de políticas para garantizar que los desarrolladores habilitados para IA cumplan las normas de codificación segura.

El panel Trust Agent: AI proporciona información sobre el uso de la herramienta de codificación de IA, el desarrollador que contribuye, el repositorio de código y mucho más.

El papel del desarrollador: La última línea de defensa

Aunque Trust Agent: AI le ofrece una gobernanza sin precedentes, sabemos que el desarrollador sigue siendo la última y más crítica línea de defensa. La forma más eficaz de gestionar el riesgo del código generado por IA es asegurarse de que sus desarrolladores cuentan con los conocimientos de seguridad necesarios para revisar, validar y proteger dicho código. Aquí es donde entra en juego SCW Learning, que forma parte de nuestra plataforma integral de gestión de riesgos para desarrolladores. Con SCW Learning, equipamos a sus desarrolladores con las habilidades prácticas que necesitan para aprovechar de forma segura la IA para la productividad. El producto SCW Learning incluye:

- Puntuación de confianza SCW: Una referencia pionera en el sector que cuantifica la competencia en seguridad de los desarrolladores, lo que le permite identificar qué desarrolladores están mejor equipados para manejar código generado por IA.

- Desafíos de IA: Retos de codificación interactivos y reales que enseñan específicamente a los desarrolladores a encontrar y corregir vulnerabilidades en el código generado por IA.

- Aprendizaje dirigido: Rutas de aprendizaje seleccionadas a partir de más de 200 desafíos, directrices, recorridos, Missions, misiones y Courses de IA que refuerzan los principios de codificación segura y ayudan a los desarrolladores a dominar las habilidades de seguridad necesarias para mitigar los riesgos de la IA.

Combinando la potente gobernanza de Trust Agent: AI con el desarrollo de habilidades de nuestro producto de aprendizaje, puede crear un SDLC verdaderamente seguro. Podrá identificar riesgos, aplicar políticas y capacitar a sus desarrolladores para crear código de forma más rápida y segura que nunca.

¿Listo para asegurar su viaje a la IA?

La era de la IA ya está aquí y, como responsable de producto, mi objetivo es crear soluciones que no sólo resuelvan los problemas de hoy, sino que se anticipen a los de mañana. Trust Agent: AI está diseñado para hacer precisamente eso, dándole la visibilidad y el control para gestionar los riesgos de la IA al tiempo que permite a sus equipos innovar. La versión beta de acceso anticipado ya está disponible y nos encantaría que participara en ella. No se trata solo de un nuevo producto, sino de ser pioneros en un nuevo estándar para el desarrollo seguro de software en un mundo en el que prima la IA.

Únase hoy mismo a la lista de espera de acceso anticipado.

Haga clic en el siguiente enlace y descargue el PDF de este recurso.

Secure Code Warrior está a disposición de su organización para ayudarle a proteger el código a lo largo de todo el ciclo de vida de desarrollo de software y crear una cultura en la que la ciberseguridad sea una prioridad. Tanto si es director de AppSec, desarrollador, CISO o cualquier persona implicada en la seguridad, podemos ayudar a su organización a reducir los riesgos asociados a un código inseguro.

Ver el informeReservar una demostraciónTamim Noorzad, Director de Gestión de Productos en Secure Code Warrior, es un ingeniero reconvertido en gestor de productos con más de 17 años de experiencia, especializado en productos SaaS 0-to-1.

La adopción generalizada de herramientas de codificación de IA está transformando el desarrollo de software. El 78 % de los desarrolladores1 utilizan ya la IA para aumentar la productividad, por lo que la velocidad de la innovación nunca ha sido mayor. Pero esta rápida aceleración conlleva un riesgo crítico.

Los estudios revelan que hasta el 50% del código funcionalmente correcto generado por IA es inseguro2. No se trata de un pequeño fallo, sino de un reto sistémico. Significa que cada vez que un desarrollador utiliza una herramienta como GitHub Copilot o ChatGPT, podría estar introduciendo sin saberlo nuevas vulnerabilidades en su código base. El resultado es una peligrosa mezcla de velocidad y riesgos de seguridad que la mayoría de las organizaciones no están preparadas para gestionar.

El reto de la "IA en la sombra

Sin una forma de gestionar el uso de herramientas de codificación de IA, los responsables de CISO, AppSec e ingeniería están expuestos a nuevos riesgos que no pueden ver ni medir. Cómo puede responder a preguntas cruciales como:

- ¿Qué porcentaje de nuestro código está generado por IA?

- ¿Qué MCP se están utilizando?

- ¿Qué modelos no aprobados se están utilizando?

- ¿Qué vulnerabilidades generan los distintos modelos?

La falta de visibilidad y gobernanza crea una nueva capa de riesgo e incertidumbre. Es la definición misma de "TI en la sombra", pero para su código base.

Nuestra solución - Trust Agent: AI

Creemos que se puede tener velocidad y seguridad a la vez. Estamos orgullosos de lanzar Trust Agent: AIuna nueva y potente capacidad de nuestro producto Trust Agent que proporciona la capacidad de observación y el control que necesita para adoptar con confianza la IA en su ciclo de vida de desarrollo de software. Mediante una combinación única de señales, Trust Agent: AI proporciona:

- Visibilidad: Vea qué desarrolladores están utilizando qué herramientas de codificación de IA, LLM y MCP, y en qué bases de código. Se acabó la «IA en la sombra».

- Métricas de riesgo: Conecte el código generado por IA con el nivel de conocimientos de un desarrollador y las vulnerabilidades introducidas para comprender el verdadero riesgo que se está introduciendo, a nivel de commit.

- Gobernanza: Automatice la aplicación de políticas para garantizar que los desarrolladores habilitados para IA cumplan las normas de codificación segura.

El panel Trust Agent: AI proporciona información sobre el uso de la herramienta de codificación de IA, el desarrollador que contribuye, el repositorio de código y mucho más.

El papel del desarrollador: La última línea de defensa

Aunque Trust Agent: AI le ofrece una gobernanza sin precedentes, sabemos que el desarrollador sigue siendo la última y más crítica línea de defensa. La forma más eficaz de gestionar el riesgo del código generado por IA es asegurarse de que sus desarrolladores cuentan con los conocimientos de seguridad necesarios para revisar, validar y proteger dicho código. Aquí es donde entra en juego SCW Learning, que forma parte de nuestra plataforma integral de gestión de riesgos para desarrolladores. Con SCW Learning, equipamos a sus desarrolladores con las habilidades prácticas que necesitan para aprovechar de forma segura la IA para la productividad. El producto SCW Learning incluye:

- Puntuación de confianza SCW: Una referencia pionera en el sector que cuantifica la competencia en seguridad de los desarrolladores, lo que le permite identificar qué desarrolladores están mejor equipados para manejar código generado por IA.

- Desafíos de IA: Retos de codificación interactivos y reales que enseñan específicamente a los desarrolladores a encontrar y corregir vulnerabilidades en el código generado por IA.

- Aprendizaje dirigido: Rutas de aprendizaje seleccionadas a partir de más de 200 desafíos, directrices, recorridos, Missions, misiones y Courses de IA que refuerzan los principios de codificación segura y ayudan a los desarrolladores a dominar las habilidades de seguridad necesarias para mitigar los riesgos de la IA.

Combinando la potente gobernanza de Trust Agent: AI con el desarrollo de habilidades de nuestro producto de aprendizaje, puede crear un SDLC verdaderamente seguro. Podrá identificar riesgos, aplicar políticas y capacitar a sus desarrolladores para crear código de forma más rápida y segura que nunca.

¿Listo para asegurar su viaje a la IA?

La era de la IA ya está aquí y, como responsable de producto, mi objetivo es crear soluciones que no sólo resuelvan los problemas de hoy, sino que se anticipen a los de mañana. Trust Agent: AI está diseñado para hacer precisamente eso, dándole la visibilidad y el control para gestionar los riesgos de la IA al tiempo que permite a sus equipos innovar. La versión beta de acceso anticipado ya está disponible y nos encantaría que participara en ella. No se trata solo de un nuevo producto, sino de ser pioneros en un nuevo estándar para el desarrollo seguro de software en un mundo en el que prima la IA.

Únase hoy mismo a la lista de espera de acceso anticipado.

Índice

Secure Code Warrior está a disposición de su organización para ayudarle a proteger el código a lo largo de todo el ciclo de vida de desarrollo de software y crear una cultura en la que la ciberseguridad sea una prioridad. Tanto si es director de AppSec, desarrollador, CISO o cualquier persona implicada en la seguridad, podemos ayudar a su organización a reducir los riesgos asociados a un código inseguro.

Reservar una demostraciónDescargarRecursos para empezar

Ley de Resiliencia Cibernética (CRA) Vías de aprendizaje alineadas

SCW apoya la preparación para la Ley de Resiliencia Cibernética (CRA) con misiones alineadas con la CRA y colecciones de aprendizaje conceptual que ayudan a los equipos de desarrollo a crear habilidades de diseño seguro, SDLC y codificación segura alineadas con los principios de desarrollo seguro de la CRA.

La Cámara de Comercio establece el estándar para la seguridad impulsada por desarrolladores a gran escala

Kamer van Koophandel comparte cómo ha integrado la codificación segura en el desarrollo diario mediante certificaciones basadas en roles, evaluaciones comparativas de Trust Score y una cultura de responsabilidad compartida en materia de seguridad.

Modelado de amenazas con IA: convertir a cada desarrollador en un modelador de amenazas

Saldrá mejor equipado para ayudar a los desarrolladores a combinar ideas y técnicas de modelado de amenazas con las herramientas de IA que ya utilizan para reforzar la seguridad, mejorar la colaboración y crear software más resistente desde el principio.

Recursos para empezar

SCW cumple 11 años: una lección en tiempo real sobre adaptabilidad y mejora continua

2025 fue un año importante para la IA, la ciberseguridad y SCW. Afronto 2026 con una confianza tranquila y el optimismo que solo puede aportar el trabajo duro que da sus frutos.

Nueva categoría de riesgo en el Top Ten de OWASP: Esperar lo inesperado

OWASP Top 10 2025 añade la gestión incorrecta de condiciones excepcionales en el número 10. Mitigue los riesgos mediante una lógica "fail closed", gestores de errores globales y una estricta validación de entradas.

OWASP Top 10 2025: Fallos en la cadena de suministro de software

OWASP Top 10 2025 sitúa los fallos de la cadena de suministro de software en el puesto número 3. Mitigue este riesgo de alto impacto mediante SBOM estrictos, seguimiento de dependencias y refuerzo de la canalización CI/CD.

.avif)

%20(1).avif)

.avif)

.avif)