Agente fiduciario de SCW: AI

Visibilidad y control completos del código generado por IA. Innove de forma rápida y segura.

%201.avif)

Mejora de la productividad,

pero aumenta el riesgo

La adopción generalizada de herramientas de codificación de IA, LLM y MCP plantea un nuevo reto: la falta de visibilidad y gobernanza sobre el código generado por IA.

78%

- StackOverflow

30%

- arXiv

50%

- BaxBench

Las ventajas del agente de confianza: AI

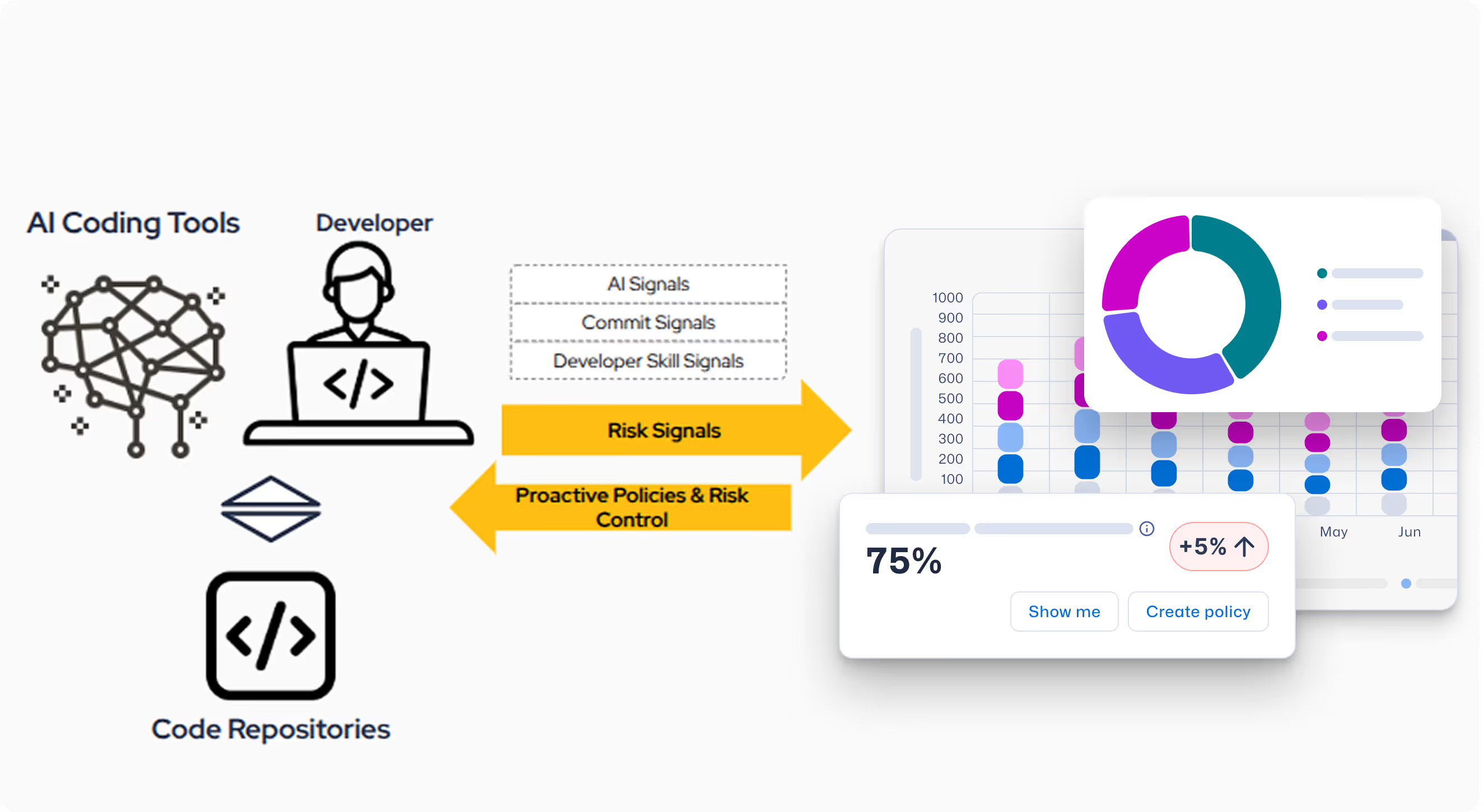

Las nuevas capacidades de IA de SCW Trust Agent proporcionan la capacidad de observación y el control que necesita para gestionar con confianza la adopción de IA en su ciclo de vida de desarrollo de software (SDLC) sin sacrificar la seguridad.

El reto de la IA en su SDLC

Sin una forma de gestionar el uso de la IA, los responsables de CISO, AppSec e ingeniería están expuestos a nuevos riesgos y preguntas que no pueden responder. Algunas de las preocupaciones son:

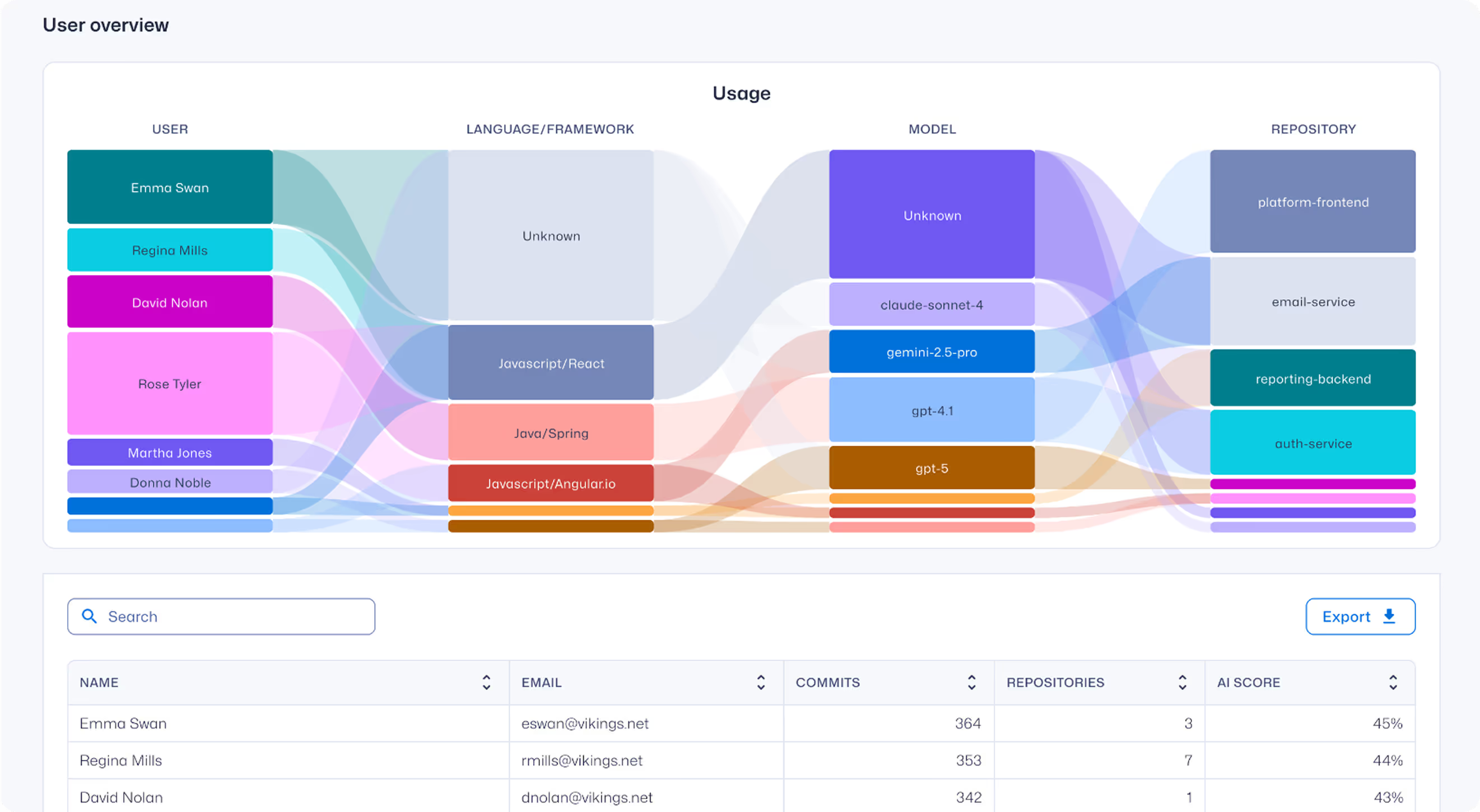

- Falta de visibilidad sobre qué desarrolladores utilizan qué modelos.

- Incertidumbre en torno a la competencia en materia de seguridad de los desarrolladores que utilizan herramientas de codificación de IA.

- No se sabe qué porcentaje del código aportado está generado por IA.

- Incapacidad de aplicar políticas y gobernanza para gestionar el riesgo de las herramientas de codificación de IA.

Nuestra solución -

Trust Agent: AI

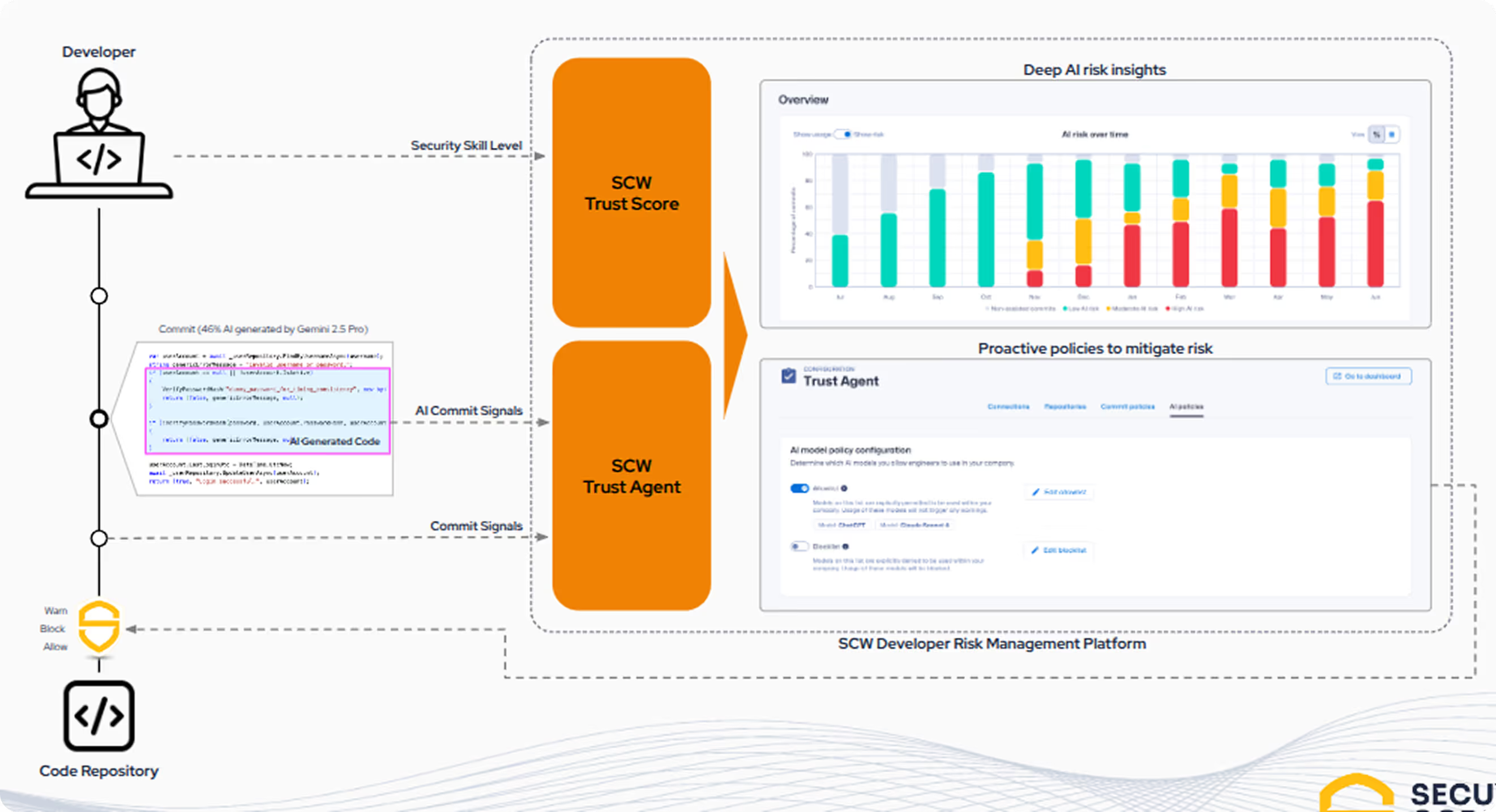

SCW permite a las organizaciones adoptar la velocidad del desarrollo impulsado por la IA sin sacrificar la seguridad. Trust Agent: AI es la primera solución que proporciona visibilidad y gobernanza mediante la correlación de una combinación única de tres señales clave para comprender el riesgo del desarrollador asistido por IA a nivel de commit.

- Uso de herramientas de codificación de IA: información sobre quién utiliza qué herramientas de codificación de IA, LLM y MCP, y en qué repositorios de código.

- Señales captadas en tiempo real: Agente de confianza: AI intercepta el código generado por la IA en el ordenador y el IDE del desarrollador.

- Habilidades de codificación segura de los desarrolladores: Proporcionamos una comprensión clara de la competencia de codificación segura de un desarrollador, que es la habilidad fundamental necesaria para utilizar la IA de forma responsable.

Se acabó la "IA en la sombra"

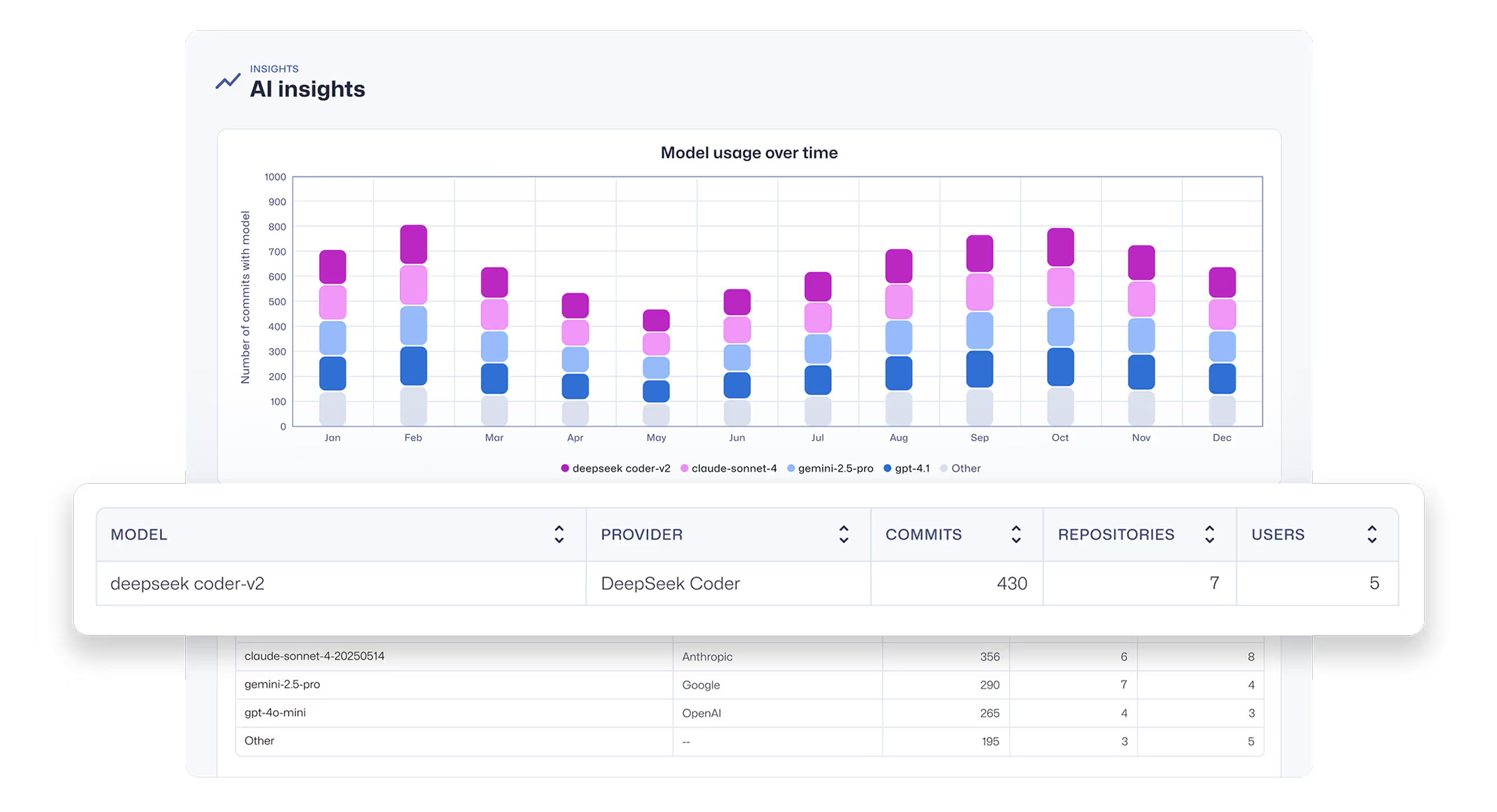

Obtenga una imagen completa de los asistentes y agentes de codificación de IA, así como de los LLM que los impulsan. Descubre herramientas y modelos no aprobados.

Observabilidad profunda de los commits

Obtenga una visibilidad profunda del desarrollo de software asistido por IA, incluyendo qué desarrolladores están utilizando qué modelos LLM y MCP, y en qué bases de código.

Gobernanza y control integrados

Conecte el código generado por IA con los commits reales para comprender el verdadero riesgo de seguridad que se está introduciendo. Automatice la aplicación de políticas para garantizar que los desarrolladores con IA cumplen las normas de codificación segura antes de que se acepten sus contribuciones.

Preguntas sobre el agente fiduciario: AI Insights

¿Por qué debería preocuparme por los riesgos del código generado por IA/LLM en mi SDLC?

A medida que los desarrolladores aprovechan cada vez más las herramientas de codificación de IA, se está introduciendo una nueva capa crítica de riesgo en los SDLC. Las encuestas muestran que el 78 % de los desarrolladores utilizan estas herramientas, pero los estudios revelan que hasta el 50 % del código generado por IA contiene fallos de seguridad.

Esta falta de gobernanza y la desconexión entre los conocimientos de los desarrolladores y la calidad del código pueden descontrolarse rápidamente, ya que cada componente inseguro generado por IA se suma a la superficie de ataque de su organización, complicando los esfuerzos para gestionar el riesgo y mantener el cumplimiento.

Más información en este informe: Asistentes de codificación de IA: Guía de navegación segura para la próxima generación de desarrolladores

¿Qué modelos y herramientas detecta Trust Agent: AI detecta?

Agente de confianza: AI recopila señales de asistentes de IA y herramientas de codificación agéntica como GitHub Copilot, Cline, Roo Code, etc. y los LLM que los alimentan.

Actualmente detectamos todos los modelos proporcionados por OpenAI, Amazon Bedrock, Google Vertex AI y Github Copilot.

¿Cómo se instala Trust Agent: AI?

Le proporcionaremos un archivo .vsix para la instalación manual en Visual Studio Code, y la implantación automatizada mediante scripts de gestión de dispositivos móviles (MDM) para Intune, Jamf y Kanji estará disponible en breve.

¿Cómo puedo inscribirme en Trust Agent: AI?

Trust Agent: La IA se encuentra actualmente en fase beta. Si está interesado, inscríbase en nuestra lista de espera para acceso anticipado.

Recursos para empezar

Codificación segura en la era de la IA: pruebe nuestros nuevos retos interactivos de IA

La codificación asistida por IA está cambiando el desarrollo. Prueba nuestros nuevos retos de IA al estilo Copilot para revisar, analizar y corregir código de forma segura en flujos de trabajo realistas.

Vibe Coding: Guía práctica para actualizar su estrategia AppSec para la IA

Vea el vídeo a la carta para aprender a capacitar a los administradores de AppSec para que se conviertan en facilitadores de IA, en lugar de bloqueadores, mediante un enfoque práctico que da prioridad a la formación. Le mostraremos cómo aprovechar Secure Code Warrior (SCW) para actualizar estratégicamente su estrategia de AppSec para la era de los asistentes de codificación de IA.

Asistentes de codificación de IA: Guía de navegación segura para la próxima generación de desarrolladores

Los grandes modelos lingüísticos ofrecen ventajas irresistibles en velocidad y productividad, pero también introducen riesgos innegables para la empresa. Las barandillas de seguridad tradicionales no bastan para controlar el diluvio. Los desarrolladores necesitan conocimientos de seguridad precisos y verificados para identificar y prevenir los fallos de seguridad desde el principio del ciclo de vida de desarrollo del software.

Recursos para empezar

SCW cumple 11 años: una lección en tiempo real sobre adaptabilidad y mejora continua

2025 fue un año importante para la IA, la ciberseguridad y SCW. Afronto 2026 con una confianza tranquila y el optimismo que solo puede aportar el trabajo duro que da sus frutos.

Ley de Resiliencia Cibernética (CRA) Vías de aprendizaje alineadas

SCW apoya la preparación para la Ley de Resiliencia Cibernética (CRA) con misiones alineadas con la CRA y colecciones de aprendizaje conceptual que ayudan a los equipos de desarrollo a crear habilidades de diseño seguro, SDLC y codificación segura alineadas con los principios de desarrollo seguro de la CRA.

La Cámara de Comercio establece el estándar para la seguridad impulsada por desarrolladores a gran escala

Kamer van Koophandel comparte cómo ha integrado la codificación segura en el desarrollo diario mediante certificaciones basadas en roles, evaluaciones comparativas de Trust Score y una cultura de responsabilidad compartida en materia de seguridad.

.avif)

.avif)